HumanNeRF: AI renders 3D humans from video only ( HumanNeRF:AI僅從視頻中渲染3D人類 )(轉貼)

HumanNeRF:AI僅從視頻中渲染3D人類

(CPVR 2022 在 USA New Orleans 新奧爾良 June 19-24, 2022)

引用 :

2022 年 6 月 21 日 Maximilian Schreiner

Image: Weng et al. | University of Washington | Google | YouTube

神經渲染方法有望用人工智能增強甚至取代歷史悠久的 3D 渲染方法。一個例子是所謂的神經輻射場 (NeRFs),這是一種小型神經網絡,可以從 2D 照片中學習 3D 表示,然後進行渲染。 自發明以來,該技術一直在產生越來越逼真的圖像。一些變體現在可以在幾秒鐘內學習和渲染複雜的 3D 表示。例如,在今年的 GTC 上,英偉達對 Instant NeRF 提出了見解,這種方法比舊方法快 1000 倍。 根據 Nvidia 圖形研究副總裁 David Luebke 的說法,對於 2D 攝影,NeRF 可與 JPEG 壓縮相媲美。他解釋說,如果像多邊形網格這樣的傳統 3D 表示可以與矢量圖像相媲美,那麼 NeRF 就像位圖圖像。它們捕捉光線如何從物體或場景中輻射出來。 Luebke 說,這可以在捕獲和共享 3D 內容時大大提高速度、簡單性和覆蓋範圍。 谷歌通過谷歌地圖部署 NeRF 以實現沉浸式視圖 NeRF 開發的先驅是谷歌。該公司與加州大學伯克利分校和加州大學聖地亞哥分校的科學家一起開發了 NeRFs。從那時起,谷歌就展示了人工智能渲染的街區,這些街區可以通過 Mip-NeRF 360 實現一種街景 3D 和真實世界物體的逼真 3D 渲染。

在今年的 CVPR I/O 開發者大會上,谷歌展示了 Immersive View,這是一種合成 3D 視角的主要城市和餐廳等個人內部視圖,同樣基於神經渲染。

Video: Google

現在,華盛頓大學和谷歌的研究人員展示了 NeRFs 如何以 3D 形式呈現人。

NeRFs for people:運動和服裝一直是一個挑戰一直到現在

新的 HumanNeRF 方法解決了用 NeRF 表示人的兩個問題:到目前為止,網絡主要處理靜態對象並依賴於多個角度的相機拍攝。 相比之下,HumanNeRF 可以從以前看不見的角度渲染運動的人,包括他們衣服的運動——從單個攝像機的角度使用培訓材料。 這意味著

NeRF 也可以通過 YouTube 視頻進行訓練,例如,正面拍攝一個跳舞的人。

Video: Weng et al. | University of Washington | Google

HumanNeRF 依賴於多個網絡,這些網絡以所謂的 T 姿勢捕獲人的規範表示,以及學習剛性骨骼運動和非剛性運動(如服裝)的所謂運動場。 被拍攝人物的姿勢還通過一個簡單的姿勢估計網絡來捕獲。 運動場和姿態估計的學習信息然後可以根據視頻中顯示的姿態修改學習到的規範表示,然後從 NeRF 進行渲染。 對於谷歌來說,HumanNeRF 只是一個開始 因此,該方法比以前的方法能夠實現更逼真的 3D 渲染:渲染的人物更加細緻,衣服的動作清晰可見。 在幾個示例中,研究人員表明,單個攝像機角度足以進行 3D 渲染——因此可以在野外使用,例如用於 YouTube 視頻。

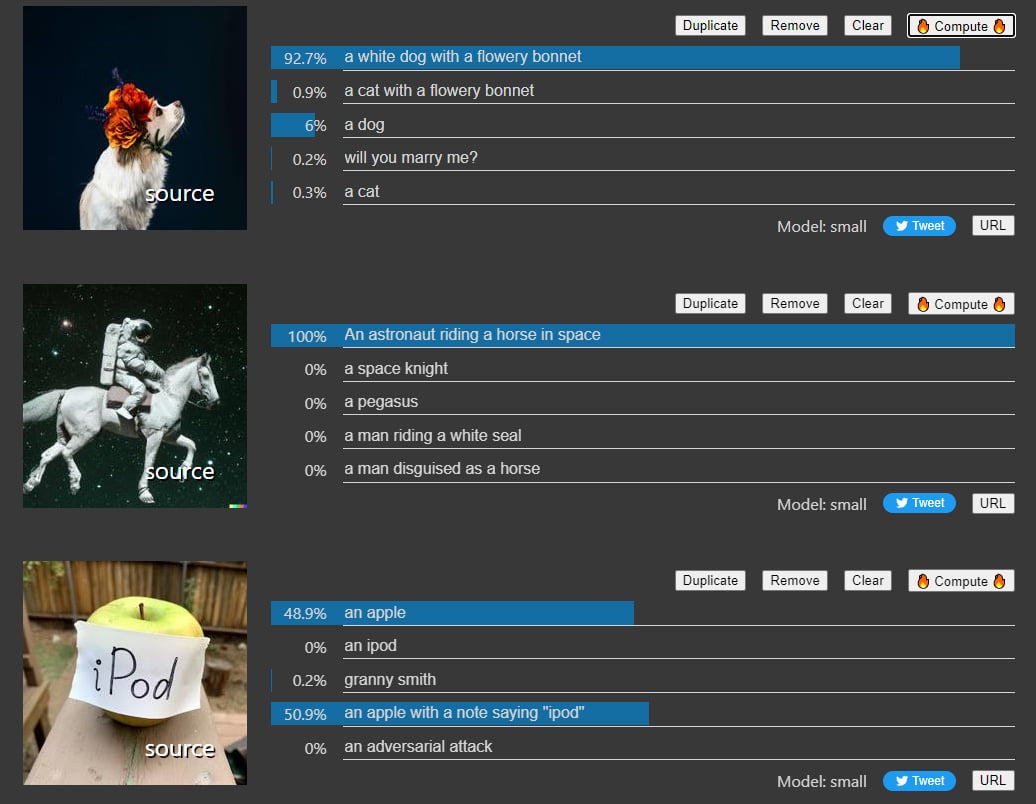

HumanNeRF achieves significantly better results than other methods. | Image: Weng et al.

HumanNeRF 還可以在訓練後從直接相反的角度渲染完整的學習場景——這尤其具有挑戰性,因為在訓練期間沒有一個渲染像素是可見的。

作為限制,研究人員引用了在不同姿勢之間的轉換過程中缺失的細節和可察覺的抖動,因為沒有考慮運動場中的時間相干性。 技術進步也有其代價:在四個 GeForce RTX 2080 Ti GPU 上訓練需要 72 小時。 然而,該團隊指出了 Nvidia 的 Instant-NGP 等發現,它大大降低了 NeRF 和其他神經渲染方法所需的計算能力。 因此,通過一些改進和更低的計算要求,這項技術最終可以接觸到最終用戶,並為谷歌提供了另一個構建 AR 未來的基石,這在今年的 I/O 大會上得到了明確的描繪。

資料來源:

Sources: HumanNeRF (Projektseite)

留言

張貼留言